Im ersten Teil hatten wir die ggrundlegende Dinge und auch schon die Auswahl einer Netzwerkkarte. Im 2. Teil kommen dann weitere Hürden.

Die Asus XG C100c

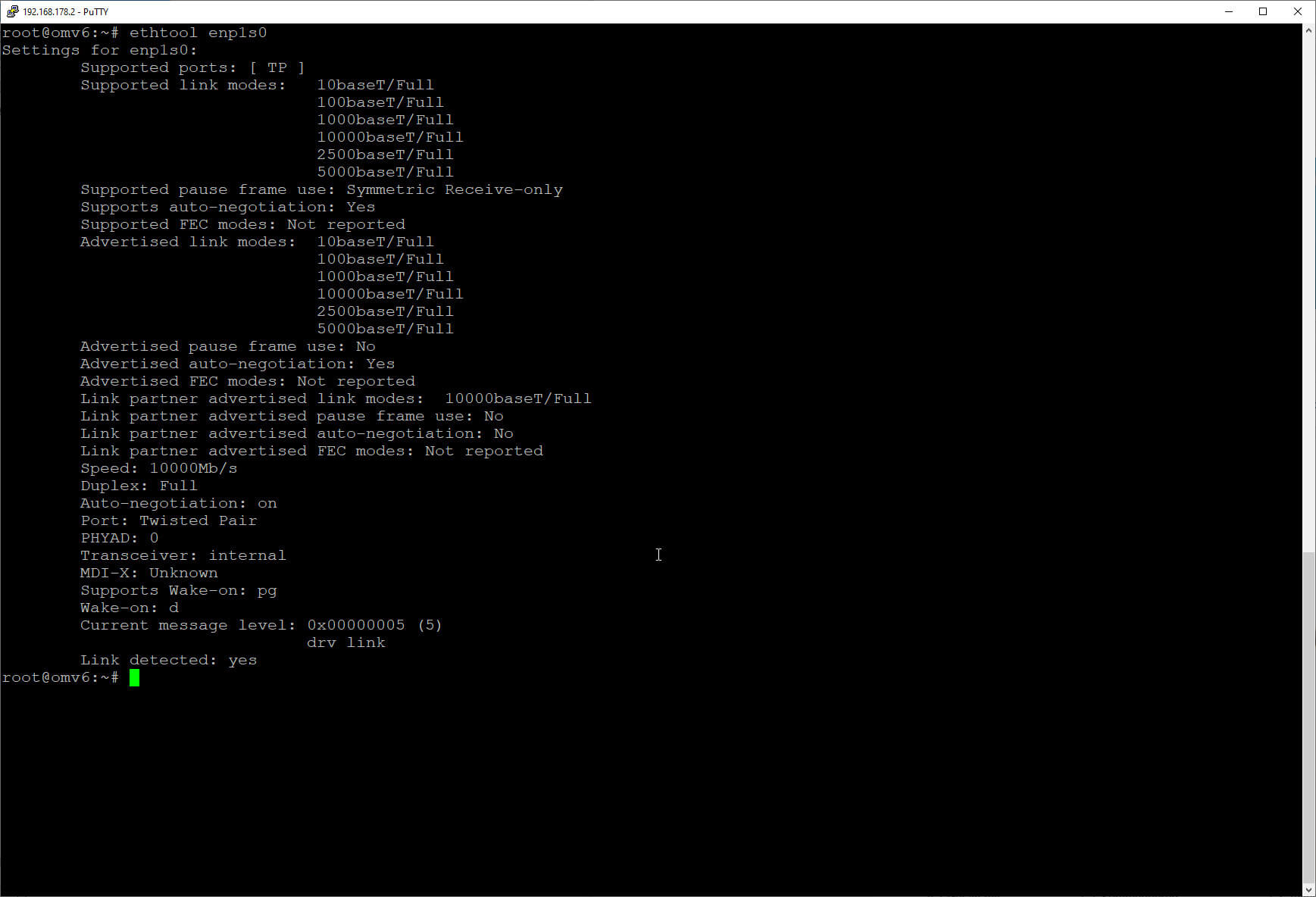

Die Karte war eigentlich problemlos einzurichten. In Openmediavault wurde ein Treiber von Aquantia aktiviert und somit konnte die Karte auch dort als weiteres Netzwerkgerät eingerichtet werden.

Die Karte wird auch problemlos erkannt und auch die maximale Geschwindigkeit. Die alternativen Geschwindigkeiten 5 GBit,2,5 G und 1 G werden unter Linux ebenfalls korrekt erkannt.

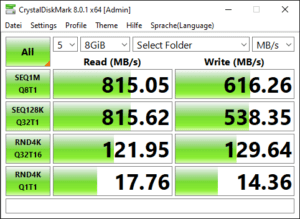

Messung Jumpo-Packete

Die dann erreichbare Geschwindigkeit ist zunächst beeindruckend. Dies gilt insbesondere wenn man die ganze Zeit über die Geschwingkeit im GB Ethernet gewohnt ist. Und aktiviert man die sogenannten Jumbo-Frames (damit werden größere Netzwerkpackete übertragen) verbessert sich die Situation ein wenig, aber von mehr als 1000MB/sec. ist man noch sehr weit entfernt.

Das hätte aber ausgereicht, um z.B. Videoclips direkt vom Server aus zu bearbeiten, ohne sie lokal zwischen zu speichern.

Und wie schon im ersten Teil berichtet, brechen die Übertragungsraten ein, wenn das NAS aufgrund der Größe der Dateien diese tatsächlich während der Übetrtragung auf Festplatte schreiben muss.

Das neue Board

Das Board des NAS ist ein mittlerweile 7 Jahre altes Asus B85M-G mit einem Intel Celeron G1820 an Board. Das Board stellt nur PCI e 2.0 zur Verfügung und der Celeron ist natürlich auch kein Rennpferd. Für das bisherige GB Ethernet war der Prozessor allerdings ausreichend war.

Das Board des NAS ist ein mittlerweile 7 Jahre altes Asus B85M-G mit einem Intel Celeron G1820 an Board. Das Board stellt nur PCI e 2.0 zur Verfügung und der Celeron ist natürlich auch kein Rennpferd. Für das bisherige GB Ethernet war der Prozessor allerdings ausreichend war.

Ich habe deshalb entschieden hier ein Upgrade durchzuführen und Mainboard und CPU zu erneuern. Die Wahl ist auf ein MSI B-560M A Pro Board gefallen. Das ist ein mATX Board mit 6 SATA Anschlüssen. Das eröffnet mir die Möglichkeit, später vielleicht auf ein kleineres Gehäuse um zusteigen.

Bei der CPU habe ich mich für eine I3-10105, also eine der 10TH Generation entschieden. Es ist eine CPU mit einer eingebauten Grafikeinheit, damit die wenigen Kartensteckplätze nicht noch für eine Grafikkarte opfen muss.

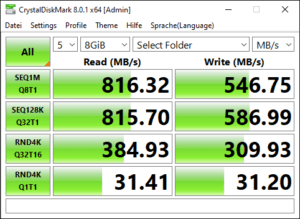

Messung MSI B-560M Board

Der Zusammenbau ging eigentlich problemlos und ich konnte das Board ersetzen. Danach wurden die Festplatten angeschlossen und ich konnte Openmediavault ohne Probleme starten. Das liegt vor allem daran, dass mittlerweile unter Linux wohl alle Platten mit einer UUID gemountet werden und nicht mit dem Namen des Anschlusses.

Aber ihr könnt euch sicherlich die Enttäuschung vorstellen, als ich trotz des neuen Boards under der CPU feststellen musste, dass sich die Überragungsraten nicht wirklich geändert hatten, zumindest in Bezug auf das sequentielle

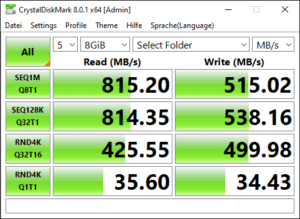

Schreiben auf SSD Laufwerk

Lesen ud Schreiben. Dafür hatte sicher aber die Geschwindigkeit der Random Zugriffe praktisch verdoppelt. Die PCI Karte befand sich in dem PCI e X16 Steckplatz, da andere zu klein waren und ich auch keine Grafikkarte benötige.

Da aber die nicht ausreichende Schreibgeschwindigkeit selbst dann festzustellen war, wenn ich auf ein Laufwerk geschrieben habe, dass durch eine SATA-SSD bereitgestellt wird, musste das Problem irgendwo anders liegen.

Nur gab es hier nochmals eine signifikaten Steigerung der Schreib- und auch Leseraten bei Random Zugriffen, während die Raten bei den sequentiellen Zugriffen gleich blieb.

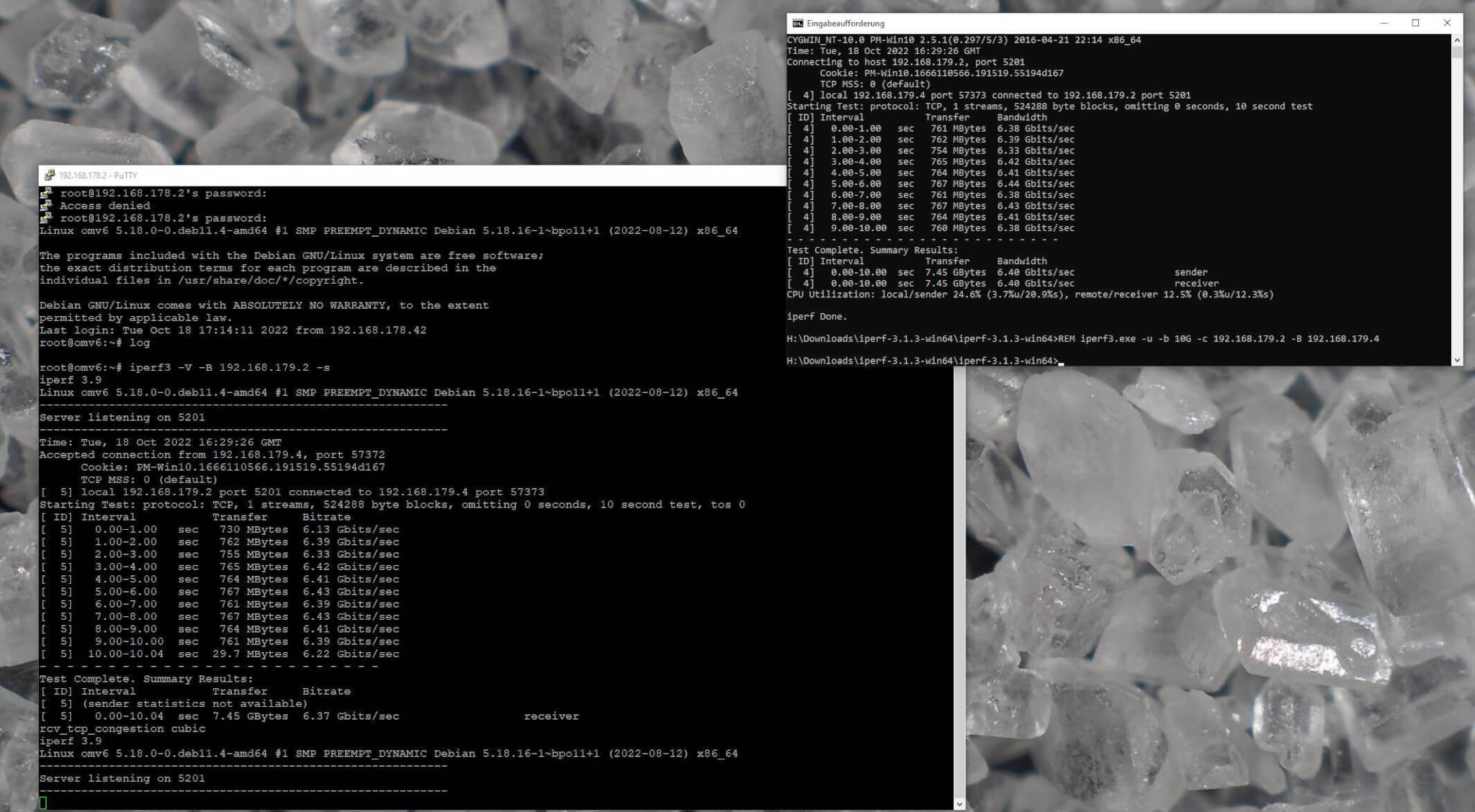

Um die Datenübertragung etwas neutraler zu messen, habe ich mir das Tool iperf3 heruntergeladen, daß es praktisch für alle Betriebssysteme gibt, und den nackten Traffic ohne Einfluss von Festplatten,RAM und anderen Dingen misst.

Aber hier konnte ich machen, was ich wollte, mehr wie 6-6,5 GBit/Sec waren nicht drin, auch wenn ich mehrere iperf3 Prozesse gestartet habe.

Wie ich das gelöst habe, können wir im 3. Teil lesen.

ciao tuxoche